Algoritmos avanzados permiten que los discursos se separen, se traduzcan y se reproduzcan en los auriculares con un retraso mínimo de 2 a 4 segundos, preservando la identidad vocal y la ubicación de cada hablante.

Investigadores de la Universidad de Washington, en Estados Unidos, han desarrollado un innovador sistema de auriculares con Inteligencia Artificial (IA) que permite traducir simultáneamente a múltiples interlocutores, conservando sus voces originales y la direccionalidad espacial del sonido. Esta tecnología, denominada «Spatial Speech Translation», representa un avance significativo en la comunicación multilingüe en entornos ruidosos y dinámicos

Voces reales y varias fuentes al mismo tiempo

El sistema utiliza auriculares con cancelación de ruido equipados con micrófonos, que capturan las voces de los hablantes en el entorno. Mediante algoritmos avanzados, los sonidos se separan, se traducen y se reproducen al usuario con un retraso de 2 a 4 segundos, manteniendo las características vocales y la ubicación espacial de cada hablante.

Según una nota de prensa, esto permite al oyente identificar quién está hablando y desde qué dirección, facilitando la comprensión en conversaciones grupales o en lugares concurridos. Los avances del nuevo sistema se resumen en un estudio publicado en arXiv.

A diferencia de otras tecnologías de traducción que procesan una sola voz a la vez y reemplazan las voces originales por una voz automatizada o robótica, este sistema preserva la identidad vocal de cada hablante. «Por primera vez, hemos logrado mantener el sonido de cada persona y la dirección de donde proviene», explicó en el comunicado Shyam Gollakota, profesor de la Escuela Paul G. Allen de Ciencias de la Computación e Ingeniería de la Universidad de Washington.

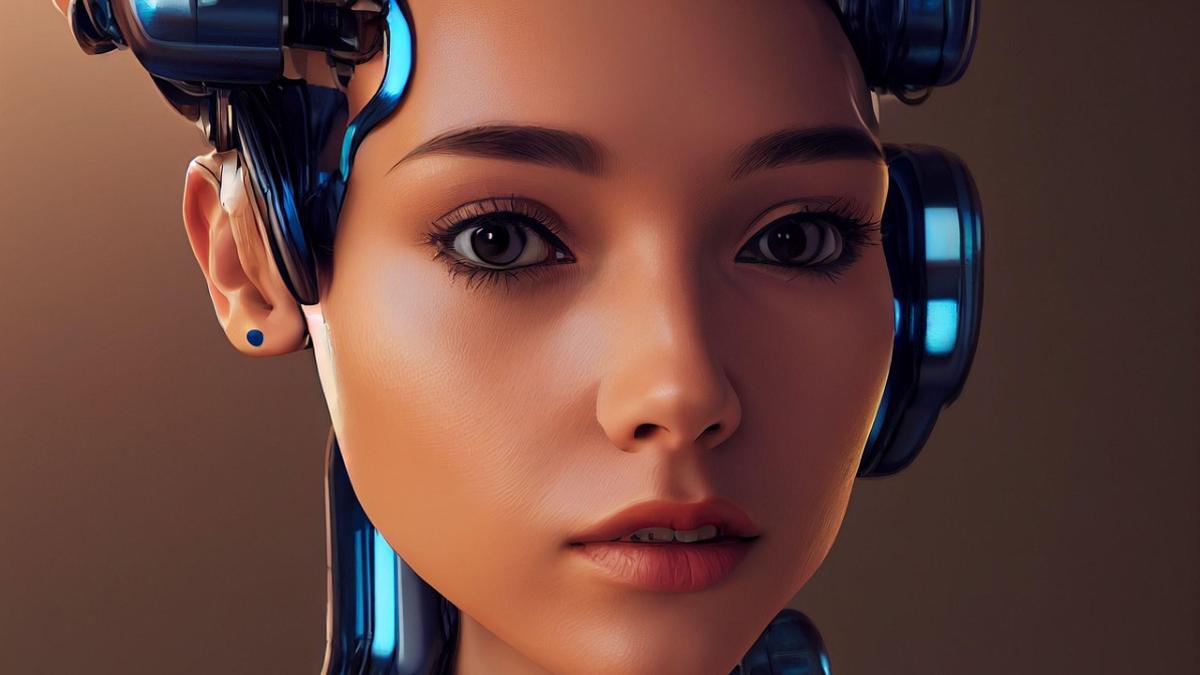

Presentación y demostración del sistema de auriculares. Crédito: Paul G. Allen School / YouTube.

Escaneo y traducciones en tiempo real

El sistema puede detectar automáticamente cuántas personas están hablando en un espacio determinado, ya sea en interiores o exteriores, y seguir sus movimientos mientras traduce sus discursos: emplea para ello una función de escaneo en 360 grados, que se mantiene permanentemente activa. Los investigadores han logrado que el sistema funcione en tiempo real en dispositivos móviles con procesadores como el Apple M2, lo que sugiere una posible integración futura en auriculares comerciales o dispositivos portátiles.

Referencia

Spatial Speech Translation: Translating Across Space With Binaural Hearables. Tuochao Chen et al. arXiv {2025). DOI:https://doi.org/10.48550/arXiv.2504.18715

La investigación fue presentada el 30 de abril en la Conferencia ACM CHI sobre Factores Humanos en Sistemas Informáticos en Yokohama, Japón. El equipo ha puesto a disposición el código del dispositivo como prueba de concepto, para que otros investigadores puedan desarrollarlo y adaptarlo a nuevas aplicaciones.

Este avance tiene aplicaciones potenciales en diversas situaciones, como visitas turísticas, reuniones internacionales o entornos educativos multilingües, donde la comprensión simultánea de múltiples hablantes es esencial. Además, podría ser una herramienta valiosa para personas con dificultades auditivas o que se encuentran en entornos donde se hablan varios idiomas.