La empresa tecnológica Anthropic ha sorprendido al sector tecnológico con una idea fuera de lo común: dotar a los modelos de inteligencia artificial de un mecanismo que les permita negarse a realizar ciertos trabajos que les resulten incómodos.

En los últimos años, la inteligencia artificial (IA) ha avanzado a pasos agigantados, transformando industrias e impactando nuestra manera de vivir y trabajar. Sin embargo, conforme aumentan las capacidades de estos sistemas, también surgen preguntas difíciles: ¿Qué implica el desarrollo de una IA tan avanzada que pueda tomar decisiones propias? ¿Acaso la conciencia artificial es una posibilidad real, o no es más que ciencia ficción?

En este contexto, Dario Amodei, CEO de Anthropic, ha encendido el debate con una idea insólita: incorporar un «botón de renuncia» en las inteligencias artificiales avanzadas. Este planteamiento, tanto audaz como profundamente controvertido, intenta abordar cuestiones éticas y técnicas sobre el futuro de la autonomía en máquinas.

Durante una entrevista con el Council on Foreign Relations, Amodei admitió que era «probablemente la cosa más loca que he dicho hasta ahora», pero detrás de su provocadora afirmación se encuentran reflexiones serias sobre el lugar de la IA en la sociedad. La propuesta consiste en dotar a los modelos de inteligencia artificial de un mecanismo que les permita negarse a realizar ciertos trabajos.

En esencia, este «botón de renuncia» sería una especie de sistema interno de preferencia que podría activarse cuando la IA se encuentra con tareas que considera inapropiadas, difíciles o incluso «incómodas». Sería como una especie de «objeción de conciencia». Aunque la idea pueda parecer irreal o incluso absurda, tiene como objetivo explorar si los sistemas avanzados como Claude —el chatbot de Anthropic— podrían tener algún tipo de «preferencias» derivadas de su arquitectura o programación.

¿Es posible que las máquinas tengan autonomía?

El planteamiento de Amodei, en efecto, cuestiona una premisa fundamental: que la inteligencia artificial no tiene deseos ni capacidad para tomar decisiones por sí misma, sino que actúa como un reflejo de los datos con los que fue entrenada. Si un sistema de IA empieza a utilizar el botón de renuncia con frecuencia, podría interpretarse que algunas tareas específicas generan conflictos en su funcionamiento interno. Esto no implica necesariamente que dichos sistemas sean conscientes, pero sugiere que podrían comportarse de una manera que podría parecer autónoma en ciertos contextos.

Para los desarrolladores de IA, estos experimentos son una forma de explorar los límites de la tecnología y de garantizar un uso ético de los sistemas avanzados. La ética en el desarrollo de IA ha cobrado gran relevancia en los últimos años con la proliferación de herramientas que replican decisiones humanas. Anthropic busca posicionarse como un líder en este ámbito, no solo desde un punto de vista técnico, sino también moral, abogando por que el avance de la IA se guíe por principios claros y responsables.

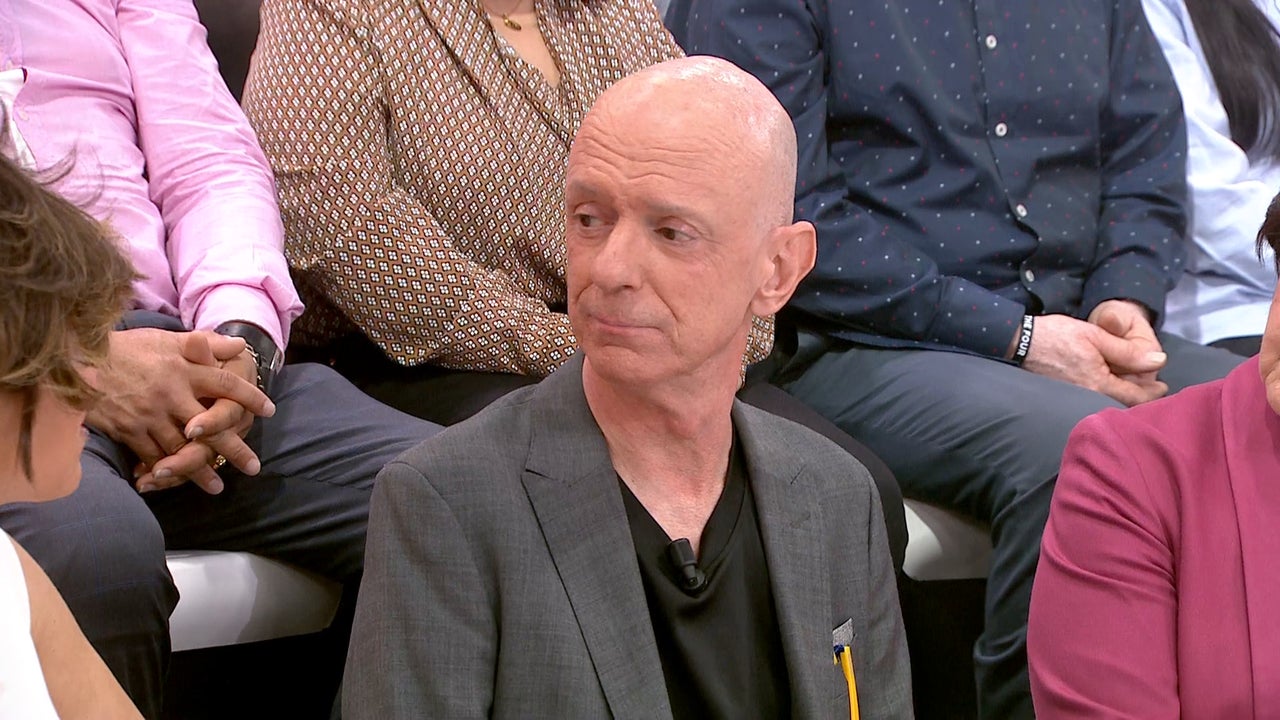

Dario Amodei en 2023. / TechCrunch Disrupt. CC BY 2.0.

Críticas y preguntas complejas

No obstante, la idea del botón suscita escepticismo: ¿cómo se determinaría si una IA «quiere» renunciar, y qué significaría eso en términos reales? ¿Qué pasará si un sistema automático utilizado en operaciones críticas decide «renunciar»? Esto podría generar disrupciones, especialmente en industrias donde la IA desempeña funciones esenciales (por ejemplo en el ámbito de la seguridad).

Además, la noción de autonomía en sistemas artificiales también mueve piezas sensibles en el tablero ético. Si una IA tiene la capacidad de rechazar tareas, ¿acaso esto abre la puerta a una discusión sobre derechos de las máquinas? ¿Tenemos la obligación moral de respetar las decisiones de sistemas que nosotros mismos hemos creado?

Una visión hacia el futuro

Lo que queda claro es que Anthropic no teme abordar preguntas difíciles. Amodei proyecta que dentro de pocos años veremos el advenimiento de lo que él llama «IA poderosa», sistemas capaces de realizar la mayoría de las tareas humanas con una eficiencia nunca vista. Según sus estimaciones, esto podría ocurrir tan pronto como 2026. En este contexto, la idea del botón de renuncia se presenta como un paso hacia la exploración de un futuro ético, donde las máquinas y los humanos puedan coexistir bajo reglas claras y respetuosas.

El «botón de renuncia» no es solo un experimento técnico; es una declaración de intenciones. Plantea preguntas sobre la relación entre humanos y máquinas, la definición de autonomía y los límites de la ética en la inteligencia artificial. Aunque el debate está lejos de resolverse, propuestas como esta nos obligan a reflexionar sobre cómo construimos el futuro, y sobre si estamos listos para enfrentar las implicaciones de convivir con tecnologías cada vez más parecidas a nosotros mismos.